你是否遇到过这样的问题:窗体刚显示就闪退?数据还没加载完用户就能操作界面?窗体关闭时数据丢失?这些都与窗体生命周期的理解不当有关。

作为C#开发者,深入理解Winform窗体生命周期不仅能避免90%的界面bug,还能让你的应用更加流畅稳定。本文将通过实战代码,带你彻底掌握Load、Shown、Closing等关键事件的正确使用方式。

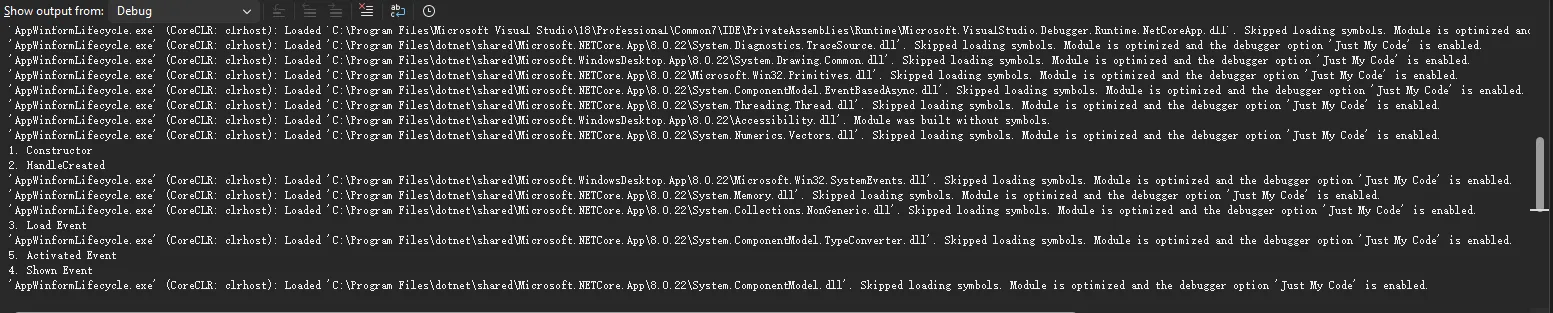

🔍 窗体生命周期全景图

📊 生命周期事件执行顺序

c#using System.Diagnostics;

namespace AppWinformLifecycle

{

public partial class Form1 : Form

{

public Form1()

{

InitializeComponent();

// 1. 构造函数 - 最先执行

Debug.WriteLine("1. Constructor");

}

protected override void OnHandleCreated(EventArgs e)

{

// 2. 句柄创建 - 窗体句柄被创建

Debug.WriteLine("2. HandleCreated");

base.OnHandleCreated(e);

}

private void Form1_Load(object sender, EventArgs e)

{

// 3. Load事件 - 窗体首次加载

Debug.WriteLine("3. Load Event");

}

protected override void OnShown(EventArgs e)

{

// 5. Shown事件 - 窗体首次显示给用户

Debug.WriteLine("4. Shown Event");

base.OnShown(e);

}

private void Form1_Activated(object sender, EventArgs e)

{

// 4. Activated事件 - 窗体获得焦点

Debug.WriteLine("5. Activated Event");

}

}

}

🚀 提示词工程入门:让AI真正听懂你的"话"

你有没有过这样的经历——明明向ChatGPT提出了需求,结果它却答非所问? 或者明明想要一篇专业报告,却只得到了几行敷衍的文字?

问题的根源往往不在AI本身,而在于我们与它"对话"的方式。就像与人沟通需要技巧一样,和AI交流同样需要掌握方法。这便是提示词工程诞生的缘由——它不是简单地"提问题",而是一门系统化的学科,帮助我们精准地驾驭大模型的能力。

据统计,优质的提示词能让AI输出质量提升300%以上。可惜的是,大多数人仍停留在"随便问问"的阶段,白白浪费了手中强大工具的潜力。今天,咱们就来彻底搞懂提示词工程这件事——从底层逻辑到实战技巧,手把手教你如何让AI成为你的"超级助理"。

🎯 提示词≠提示词工程: 别再混为一谈

什么是提示词?

简单说,提示词(Prompt)就是你给AI下达的指令。

想象一下,你走进一家餐厅,对服务员说:"给我来点吃的。"结果可能是一碗面,也可能是一盘青菜——因为你的需求太模糊了。但如果你说:"我想要一份中辣的麻婆豆腐,米饭少盛一点,再来一碗紫菜蛋花汤。"这时,服务员就能精准理解你的需求。

Python Tkinter状态栏实战:让你的GUI应用更专业

在Windows桌面应用开发中,状态栏是提升用户体验的重要元素。你是否注意到,几乎所有专业软件底部都有一个状态栏,实时显示程序状态、进度信息或操作提示?但Tkinter并没有提供原生的StatusBar组件,这让很多Python开发者感到困惑。

本文将带你从零开始,掌握Tkinter状态栏的设计与实现。我们不仅会解决"如何创建状态栏"的问题,还会深入探讨多分区显示、动态更新、进度条集成等高级特性。无论你是在开发数据采集上位机、自动化测试工具,还是桌面管理系统,这些技巧都能让你的应用界面更加专业。

🤔 为什么需要状态栏?

在深入代码之前,我们先理解状态栏的核心价值:

1. 实时反馈:后台任务执行进度、数据处理状态 2. 信息提示:操作成功/失败提示、快捷键说明 3. 状态显示:连接状态、系统时间、资源占用

典型应用场景包括:

- 串口通信软件显示连接状态

- 数据处理工具显示处理进度

- 文件管理器显示选中项数量

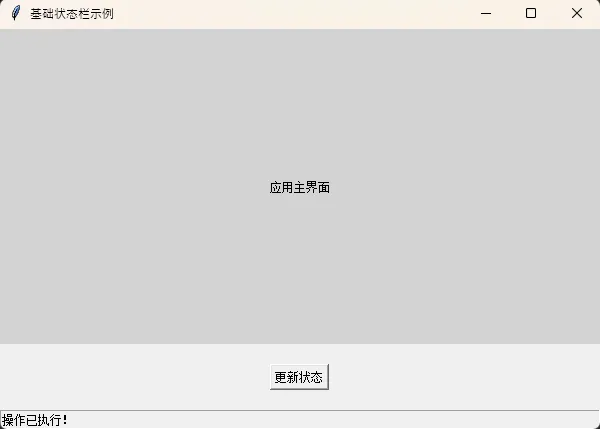

🔧 基础实现:创建第一个状态栏

Tkinter中的状态栏本质上是一个特殊样式的Frame或Label,通过布局管理器固定在窗口底部。

📌 最简单的状态栏

pythonimport tkinter as tk

from tkinter import ttk

class SimpleStatusBar:

def __init__(self, master):

self.master = master

self.master.title("基础状态栏示例")

self.master. geometry("600x400")

# 主内容区域

content = tk.Label(master, text="应用主界面", bg="lightgray")

content.pack(fill=tk.BOTH, expand=True)

# 状态栏(使用Label实现)

self.status_bar = tk.Label(

master,

text="就绪",

bd=1, # 边框宽度

relief=tk. SUNKEN, # 凹陷效果

anchor=tk.W # 左对齐

)

self.status_bar.pack(side=tk.BOTTOM, fill=tk.X)

# 测试按钮

btn = tk.Button(master, text="更新状态",

command=lambda: self.update_status("操作已执行!"))

btn.pack(pady=20)

def update_status(self, message):

"""更新状态栏文本"""

self.status_bar.config(text=message)

if __name__ == "__main__":

root = tk.Tk()

app = SimpleStatusBar(root)

root.mainloop()

关键点解析:

relief=tk.SUNKEN:创建视觉上的"嵌入"效果anchor=tk.W:文本左对齐(W代表West西方)pack(side=tk.BOTTOM, fill=tk.X):固定在底部并横向填充

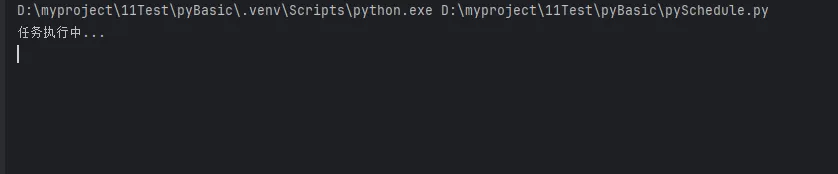

Python定时任务神器:schedule库入门实战指南

在日常的Python开发中,我们经常需要让程序在特定时间执行某些任务:每天早上8点发送邮件提醒、每隔30分钟检查服务器状态、每周清理一次临时文件等等。虽然Windows有任务计划程序,Linux有cron,但作为Python开发者,我们更希望用纯Python的方式来解决这个问题。

schedule库就是为此而生的轻量级定时任务解决方案。它语法简洁、易于理解,特别适合Python初学者和中小型项目使用。本文将带你从零开始掌握schedule库,让你的Python程序拥有"时间感知"的能力。

📋 问题分析

🤔 为什么需要定时任务?

在实际的Python开发中,我们经常遇到这样的场景:

- 数据采集:定期爬取网站数据、API调用

- 系统监控:定时检查服务状态、资源使用情况

- 文件处理:定期清理日志、备份数据

- 消息推送:定时发送邮件、微信通知

- 上位机开发:定期读取设备数据、状态检查

💭 传统解决方案的痛点

Windows任务计划程序:

- 配置复杂,需要通过GUI操作

- 难以与Python程序集成

- 调试困难,错误信息不直观

time.sleep()循环:

pythonimport time

while True:

# 执行任务

do_something()

time.sleep(3600) # 休眠1小时

- 不够灵活,难以实现复杂的时间规则

- 程序阻塞,无法处理其他逻辑

- 时间精度问题,容易产生累积误差

💡 解决方案:schedule库

🚀 安装与基本使用

安装命令:

bashpip install schedule

基本语法结构:

pythonimport schedule

def job():

print("任务执行中...")

# 设置定时任务

schedule.every(10).seconds.do(job)

schedule.every().hour.do(job)

schedule.every().day.at("09:00").do(job)

# 保持程序运行

while True:

schedule.run_pending()

time.sleep(1)

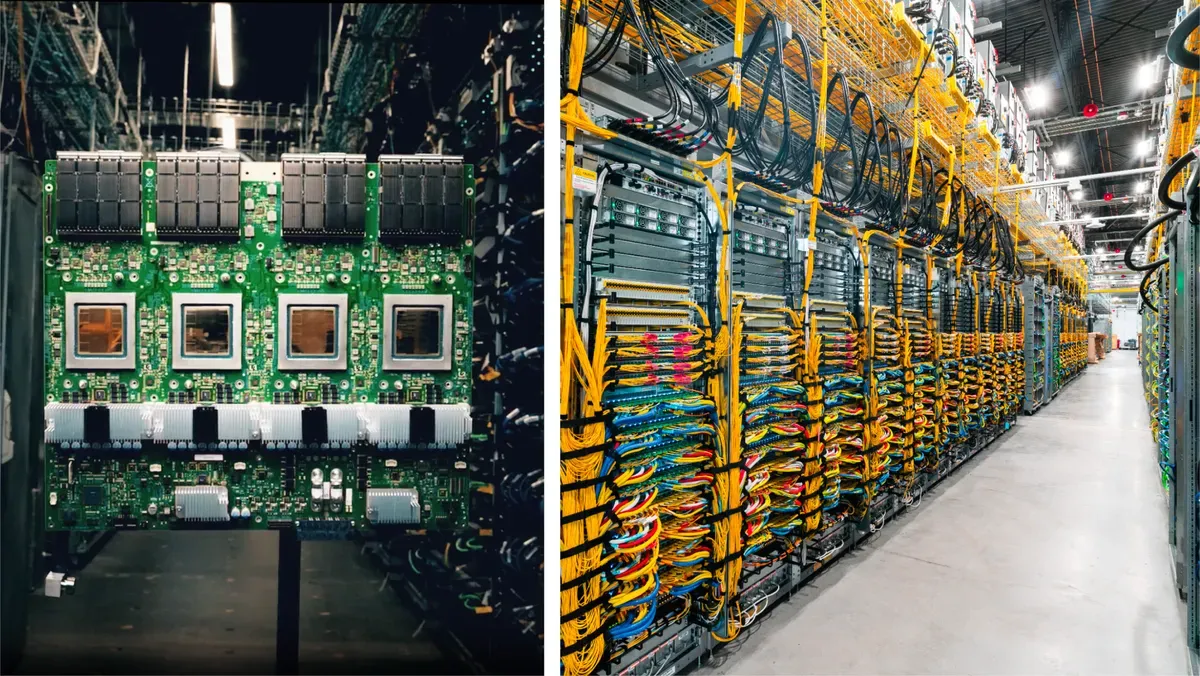

大模型硬件选型指南:从CPU到TPU的实战策略

大模型硬件选型远不止是"买最贵的"这么简单,它更像一场精心策划的烹饪艺术——不同食材需要不同的处理方式,而硬件就像厨房里的各种工具,必须根据任务需求精准匹配。从DeepSeek-R1的1.5B轻量版到671B的"巨无霸",硬件需求天差地别,选择不当可能导致模型加载缓慢、推理延迟高企,甚至根本无法运行。

🔥 硬件选型的三大陷阱与真实痛点

陷阱一:显存越大越好? 这是最常见的误区,许多用户为7B模型购买80GB显存的A100,结果发现性能提升有限,成本却高出10倍。显存确实是关键瓶颈,但盲目追求大显存就像买了一座豪华厨房却只用来煮泡面,资源严重浪费。

陷阱二:忽略CPU与内存协同。GPU虽是主力,但CPU负责数据预处理、任务调度这些"幕后工作"。实测显示,CPU推理耗时2.3秒,而GPU仅需28毫秒,若CPU性能不足,整体效率可能下降50%以上。更令人担忧的是,内存容量不足会导致模型加载缓慢,甚至崩溃。

陷阱三:TPU生态锁。TPU虽在谷歌生态内性能优异,但需依赖TensorFlow框架和谷歌云平台,跨平台兼容性差。非谷歌用户使用TPU需转换框架,可能导致开发周期延长或代码重构成本增加。

这些误区造成的实际后果不容忽视:某用户为DeepSeek-R1的7B版本购买了RTX 4090(24GB显存),结果发现性能提升有限,成本却高出10倍;另一用户仅关注GPU而忽视CPU和内存,导致系统整体性能下降50%以上;还有用户尝试在本地部署TPU,最终因生态不兼容而失败。

💡 大模型硬件架构的三大核心处理器

🎯 CPU:大模型的"指挥官"

CPU就像厨房里的"指挥官",负责统筹整个烹饪过程。虽然它处理单个任务的速度快,但并行能力有限。在大模型训练中,CPU主要负责数据预处理、任务调度和少量推理工作。选择CPU时,需关注核心数、内存带宽和是否支持AVX2/AVX-512指令集——这些直接影响模型加载速度和预处理效率。

以DeepSeek-R1的1.5B版本为例,它可以在现代CPU(如Intel i5或AMD Ryzen 7)上流畅运行,无需独立显卡。这是因为CPU的通用性足以处理小规模模型的推理需求,但若进行训练,则效率会大幅下降。

🔥 GPU:大模型训练的"蜂群"

GPU则像厨房里的"蜂群",数千个简化核心协同工作,专注于高吞吐量计算。NVIDIA的GPU在大模型训练领域占据主导地位,因其支持CUDA生态和丰富的AI加速功能。2025年最新的B200 GPU采用Blackwell架构,FP8算力达10 PFlops,支持液冷散热,可将ChatGPT训练能耗从15兆瓦降至4兆瓦。

GPU特别适合处理矩阵运算,这是大模型训练的核心任务。DeepSeek-R1的7B版本需要至少8GB显存的GPU(如RTX 3060),而32B版本则需要多张A100(80GB显存/卡)。GPU的灵活性使其成为科研机构和中小企业的首选,但高功耗和成本也是不容忽视的挑战。

🚀 TPU:谷歌的"定制化工厂"

TPU是谷歌的"秘密武器",专为AI设计的ASIC芯片,就像高度自动化的"定制化工厂"。TPU在矩阵运算上比GPU快180%,但软硬件生态封闭,仅限谷歌云平台使用。TPU v5p的BF16算力达459 TFlops,Int8下918 TOPS,集成HBM3内存,训练GPT-3-175B速度提升180%。

TPU的优势在于极致的能效比和规模扩展能力,但它的缺点也很明显:仅支持TensorFlow框架,无法在本地部署,且需额外支付谷歌云服务费用。除非你是谷歌生态深度用户,否则TPU的使用门槛较高。

就在上个月,这个火的不行,问题好像前几天NVIDIA 反手收购了TPU之父。